© Gebrüder Beetz Filmproduktion

Zehn Stunden am Tag Selbstmorde sichten

Die schmutzigen Geheimnisse von Facebook, Youtube und Co

Die schmutzigen Geheimnisse von Facebook, Youtube und Co

Mit Menschen über ihre Arbeit sprechen, die nicht über ihre Arbeit sprechen dürfen: Menschen, die für Facebook und andere soziale Netzwerke zehn Stunden am Tag Horrorinhalte sichten und löschen. Über die finsteren Details dieser Arbeit und ihre eigene Sicht auf Facebook und Co reden die Autoren, Theater- und Filmemacher Moritz Riesewieck und Hans Block im Interview.

Viele der Hunderttausenden von Fotos und Videos, die täglich in die Sozialen Netzwerke hochgeladen werden, zeigen Gewalt, Pornografie, Terror und andere abscheuliche Dinge. Doch wir sehen nichts davon – weil Facebook, Youtube und andere Unternehmen dafür sorgen.

Die Unternehmen beschäftigen Content-Moderatoren, die in Zehn-Stunden-Schichten diese Inhalte sichten und nach einem geheimen, komplexen Regelwerk entscheiden, ob die Inhalte gelöscht werden. Sie sind zu absolutem Stillschweigen über ihre Arbeit verpflichtet – eine Arbeit, die die meisten von ihnen innerlich auffrisst.

Erschütternde Geheimnisse aus erster Hand

Viele dieser Content-Moderatoren leben in Manila auf den Philippinen. Dort haben Moritz Riesewieck und Hans Block sich auf deren Spur begeben, über viele Monate Vertrauen aufgebaut und es schließlich geschafft, mit einigen der Content-Moderatoren über deren Arbeit zu sprechen.

Aus dieser umfangreichen Recherche ist in Zusammenarbeit mit dem Schauspiel Dortmund das Theaterstück „Nach Manila“ entstanden, konzipiert vom Berliner Theater- und Recherchekollektiv Laokoon. Wenig später erschien Riesewiecks Buch „Digitale Drecksarbeit. Wie uns Facebook und Co. von dem Bösen erlösen“.

Jetzt haben Block und Riesewieck einen Dokumentarfilm dazu gemacht: „The Cleaners. Im Schatten der Netzwelt“ hatte im Januar Weltpremiere beim Sundance Filmfestival, Ende April gewann er beim Moskauer Internationalen Film Festival den Preis für den besten Dokumentarfilm. Am 5. Mai ist er zum ersten Mal in NRW zu sehen: in einem Doppelabend mit dem Theaterstück „Nach Manila“.

Moritz Riesewieck (l.) und Hans Block beim Sundance Film Festival in Salt Lake City. © Courtesy of Sundance Institute

Der Film behandelt nicht nur die traumatisierende Arbeit der Content-Moderatoren, sondern auch die Frage, welche Auswirkungen es für uns hat, wenn die Sozialen Netzwerke einerseits Redefreiheit propagieren und andererseits insgeheim eine Onlinezensur betreiben, die nach Ansicht der Autoren Hass und Fake News besonders fördert.

Wir haben mit den Machern des Films, Moritz Riesewieck und Hans Block, gesprochen.

Im Januar war Ihr Film erstmals zu sehen, auf dem Sundance Film Festival in Salt Lake City. Gerade haben Sie beim Internationalen Filmfestival in Moskau gewonnen. Das wievielte Festival war das jetzt?

Moritz Riesewieck: Das zwölfte?

Hans Block: Nee, mehr. Das zwanzigste etwa. Durch Europa und Amerika. Kopenhagen, North Carolina, San Francisco, Genf, Brüssel, Prag, Toronto ...

Riesewieck: Toronto kommt noch.

Block: Genau. Es sind auf jeden Fall sehr viele Festivals, die Interesse an dem Film haben. Das bedeutet viele Reisen für uns.

Erkennen Sie da noch Unterschiede zwischen den Festivals? Zwischen den Publikumsreaktionen?

Riesewieck: Ja, schon. Zumindest, wenn es um free speech geht, ist das schon ganz interessant, dass das amerikanische Publikum gar nicht so sehr ein Problem darin sieht, wenn wir in unserem Film zum Beispiel einen haben, der mit Posts auf Facebook gegen Geflüchtete oder andere Minderheiten hetzt.

In Europa sagen die meisten Leute ja dann: „Oh mein Gott, jetzt gebt ihr dem auch noch eine Plattform in eurem Film.“ Oder andere sagen: „Ja, ich finde das schon wichtig, dass der drin ist, aber ist ja auch schwierig, ob man so jemanden zulassen will in Sozialen Medien“.

In den USA ist das für die meisten Leute völlig klar, dass der natürlich auch das Recht hat zu sprechen und seine Meinung zu äußern. Dieses first amendment (der erste Zusatzartikel zur Verfassung der USA, Anm.d.Red.) ist da schon sehr stark und prägend.

Werden Sie kritisiert für die Art und Weise, in der Sie jemandem im Film zu Wort kommen lassen?

Riesewieck: Nicht kritisiert. Aber es gibt immer diese Nachgespräche, und wenn man das dann so in den Raum stellt, als offene Frage, dann sind die meisten ziemlich klar dafür, dass so jemand in den Sozialen Medien auf jeden Fall vorkommen können sollte, während das in Europa eher in die andere Richtung geht.

In Europa sind die meisten Leute der Meinung, so was sei gefährlich. Und zwar, weil so jemand in den sozialen Medien eine große Verbreitung seiner Gedanken erreichen kann. Deshalb solle man eine klare Grenze ziehen. Im Sinne von: Das ist Hassrede, das ist Hetze, das ist keine Meinung mehr, und sollte deshalb auch nicht vorkommen dürfen.

Block: Aber ich glaube, es ist von uns auch ein bewusster Zug gewesen, dass wir als Filmemacher ja auch eine Art Content Moderatoren sind. Wir haben ja auch überlegt: Was zeigen wir den Leuten, was zeigen wir nicht?

Gewissermaßen ist es für uns auch genau richtig, an den Grenzbereichen zu operieren, wann man etwas zeigen sollte und wann nicht, um dadurch eine Diskussion auszulösen, die sonst durch Soziale Medien vielleicht nicht ausgelöst werden würde, weil man oft Content nicht sieht – und wenn man etwas nicht sieht, weiß man auch nicht, dass es existent war.

Und, naja, im anderen Fall wird natürlich darüber diskutiert, wenn's zu sehen war. Diese Fragen werden auch oft auf den Festivals diskutiert, zum Beispiel: Wie grausam kann man überhaupt sein? Also, wir zeigen ja auch Ausschnitte von Bildern, die nicht einfach sind zu ertragen.

Screenshot aus „The Cleaners“: Manila bietet für die Unternehmen des Silicon Valley ideale Bedingungen, um hier die Schmutzarbeit machen zu lassen. © Gebrüder Beetz Filmproduktion

Aber sehr wenige, nur um zu zeigen, dass es diese Bilder wirklich gibt, die man sonst eben nicht zu Gesicht bekommt, oder?

Block: Es hat noch eine weitere Bedeutung. Zum einen glauben wir schon, dass man mal fragen muss: Haben wir wirklich das Recht darauf, nicht kontaminiert oder berührt zu werden von Bildern?

Zum Beispiel: Im Falle eines Kriegsbildes aus Syrien, also einer Region, die der Westen ja über Jahrzehnte mit destabilisiert hat: Haben wir das Recht, uns davon fern zu halten und komplett unberührt zu bleiben?

Oder müssen wir nicht uns mit dem Leid, das dieser Krieg produziert, konfrontieren, weil es die Debatte ändert? Zum Beispiel haben wir kollaboriert mit einem Forscher vom MIT, Ethan Zuckerman, und die konnten nachweisen, dass das Foto des geflüchteten Jungen Alan Kurdi am Strand vom Bodrum, das ist ja jetzt schon eine Weile her, dass dieses Foto damals die Art grundlegend verändert hat, in der über die Geflüchtetenkrise diskutiert wurde.

Also dass es schon ganz wichtig war, dass man diese abstrakte Diskussion um den Krieg und um das Geflüchtetenproblem, dass man das auf eine menschlichere Ebene bekommt. Dass Menschen, die es sonst vielleicht eher abstrakt mit Angst zu tun hatten, einmal gesehen haben: Es geht da um Menschen.

Die gleiche Erkenntnis soll Ihr Film vermitteln, oder?

Riesewieck: Wir glauben schon daran, dass Bilder eine Kraft und Bedeutung haben, und dass wir uns davor nicht einfach schützen oder abschirmen können. Aber das ist nur das eine.

Der zweite und ausschlaggebende Grund, warum wir etwa das Bild eines Geköpften in den Film aufgenommen haben, war, dass man in diesem Moment eindrucksvoll sehen kann, wie die Content-Moderatorin dieses Bild behandelt. Sie hat einen fast medizinischen Blick darauf, und wie sie das beschreibt, das ähnelt eher der Diagnose eines Chirurgen.

Sie seziert das Bild, und diese Art das zu beschreiben erzählt natürlich einerseits ganz viel darüber, wie viele Bilder dieser Art sie schon gesehen haben muss, um in der Lage zu sein, zum Beispiel den Messertyp auszumachen, der in dem Fall zur Anwendung gekommen sein muss, also sie sagt, es müsse sich dabei um ein handelsübliches Küchenmesser gehandelt haben, was man an den Spuren erkennen könne. Absolut absurd, andererseits erschreckend.

Und es erzählt sehr viel über so eine Distanznahme. Also wie ist ein Mensch eigentlich in der Lage, so etwas täglich acht bis zehn Stunden zu machen. Da muss man sich ja unbewusst oder bewusst eine Möglichkeit finden, eine Distanz dazu zu entwickeln.

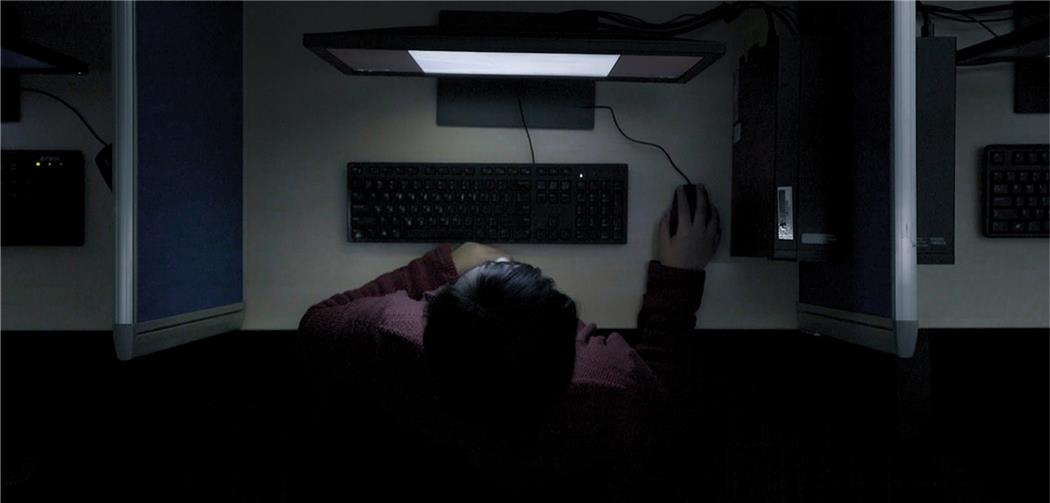

Screenshot aus „The Cleaners“: Zehn Stunden am Tag sichten die Content Moderatoren das Schlimmste, zu dem Menschen fähig sind. © Gebrüder Beetz Filmproduktion

Dass das nicht hundertprozentig funktioniert, oder nur während der Arbeit und nicht in der Freizeit oder in der Nacht, ist auch Thema Ihres Films. Dass die Leute es eben nicht schaffen, damit auf eine gesunde Art umzugehen.

Block: Ganz genau. Dieser Job, acht bis zehn Stunden sich das Übelste, was der Mensch produzieren kann, anzugucken, in einer sehr großen Intensität, hinterlässt natürlich Spuren bei den Mitarbeitern. Die sind ganz unterschiedlich auszumachen und nicht einfach zu erkennen.

Wir haben teilweise mit den Protagonisten eine sehr lange Zeit verbracht, mehr als ein Jahr, bevor wir überhaupt angefangen haben zu filmen. Dann merkt man teilweise, dass die Protagonistin sehr unruhig wird, wenn man durch Manila fährt und auf Plätze kommt, wo viele Menschen sind, und wir nach einer Weile herausbekommen, dass sie Angst hat auf großen Plätzen zu sein, weil sie den ganzen Tag Terrorvideos sichten muss, wo Terrorattacken zu sehen sind.

Oder es wird erzählt von Libidoverlust von Leuten, die sagen, ich kann nicht mehr angefasst werden, weil sie die ganze Zeit Videos von Kindesmissbrauch sehen.

Aber in dem Film geht es auch um die schlimmsten Folgen, nämlich den Selbstmord. Es gibt eine sehr hohe Suizidrate in dieser Industrie.

Wir behandeln einen Fall von einem Menschen, der täglich Selfharm-Suicide-Videos sichten muss und schon mehrmals der Firma gesagt hat, dass er diese Position nicht weiter ausfüllen möchte ...

Selfharm-Suicide-Videos – also Filme von Menschen, die sich selbst verletzen oder umbringen und sich dabei filmen?

Block: Genau. Es gibt diese Kategorie bei den Content Moderatoren, Videos, wo Leute sich verletzen, aufschlitzen, umbringen, diese Videos müssen gesichtet werden und entschieden werden: Wird das runtergenommen oder nicht? Wenn man das täglich machen muss, dann führte das in diesem Fall, über den wir in dem Film berichten, dazu, dass der sich selbst erhängt hat, vor einem Laptop. Was natürlich eine Folge seiner Arbeit ist.

Vor einem Laptop – heißt das, dieser Mann hat sich auch selbst dabei gefilmt?

Block: Das wissen wir nicht. Aber als er gefunden wurde, stand der Laptop eingeschaltet vor ihm. Und das Schwierige ist, deswegen finden wir es auch so wichtig darüber zu reden, dass die Firmen es ausnutzen, dass es bei psychischen Problemen so schwer ist herauszufinden, was die Ursache ist.

Und die Firmen haben in diesem Fall beispielsweise an alle Mitarbeiter die Warnung herausgegeben: „Dieser Fall hat nichts mit der Arbeit zu tun, und wir möchten, dass das auch so kommuniziert wird.“

Und in einem Land wie den Philippinen, wo viele Menschen verhungern oder durch ihre Jobs Wunden haben, weil sie etwa im Müll wühlen und Rattenbisse haben, fühlt sich das absurd an, wenn man über mentale Schwierigkeiten redet, über Sachen, die in einem passieren.

Aber das sind natürlich extreme Folgen. Da müssen Facebook & Co. Verantwortung übernehmen, die Augen öffnen und das beheben.

Screenshot aus „The Cleaners“: Die Content Moderatoren müssten dringend über ihre Arbeit reden, um geistig gesund zu bleiben. Aber sie dürfen nicht. © Gebrüder Beetz Filmproduktion

Sie beide beschäftigen sich auch schon seit Jahren mit diesen belastenden Inhalten. Wie geht es Ihnen psychisch?

Riesewieck: Wir haben ja kollaboriert mit einer Psychologin der University of the Philippines und einer Expertin vom Traumazentrum Berlin, und das Wichtigste im Umgang mit solchen Erfahrungen scheint zu sein, dass man jemanden hat, dem man sich anvertrauen kann und mit dem man über das Erlebte sprechen kann.

Und das ist genau das, was den Content Moderators in Manila verwehrt bleibt. Die unterschreiben extra, dass sie das nicht tun, in „non disclosure agreements“, sehr streng gehandhabt, nicht mal ihre eigenen Familien wissen in den meisten Fällen, was sie da tagtäglich machen.

Eine Mutter in dem Film sagt: „Ja, ich weiß nur, er ist Moderator. Aber was genau das heißt, weiß ich nicht.“ Wir selbst dagegen haben diese Möglichkeit, weil wir beide da drinhängen und beide den kompletten Prozess mitgemacht haben, so dass wir uns untereinander extrem viel austauschen können.

Und Sie publizieren das alles als Theaterstück, als Buch und jetzt als Film und reden mit vielen anderen Menschen auf der ganzen Welt darüber.

Block: Genau.

Die Leute auf den Philippinen dagegen werden dafür bezahlt den Schmutz einzuatmen und niemals auszuatmen.

Riesewieck: Das ist ein ganz treffendes, starkes Bild, ja.

Wenn Sie die Wahl hätten, Sie beide, würden Sie Facebook abschalten?

Block: Ich glaube, wir müssen begreifen, dass etwas passiert mit den sozialen Medien, was wir vorher noch nicht abgeschätzt haben, auch wir, als wir die Recherche begonnen haben: dass das nämlich eine Art neue digitale Infrastruktur von Kommunikation und Information geworden ist.

Es ist nicht mehr nur ein Tool, wo wir Urlaubsbilder posten oder wo man zum Geburtstag einlädt, sondern es ist ein wichtiges Informationstool der Demokratie geworden. So was wie die digitale Öffentlichkeit an sich.

Und diese Infrastruktur wollen wir gar nicht missen, also wir finden das gut und wir finden auch, dass das was sehr Utopisches hat, Leuten über Grenzen hinweg eine Stimme zu verleihen, die Möglichkeit anzubieten, zum Beispiel in regressiven Staaten neben den staatlichen Medien eine Alternative anzubieten, wo man sich informieren und verbünden kann.

All das sollten wir nicht über Bord werfen, sondern wir sollten eher die Geburtskrankheiten, die extrem vorhanden sind in den sozialen Medien, beheben und uns fragen: Wollen wir länger zulassen, dass diese neue Infrastruktur in der Hand von wenigen Menschen privater Unternehmen im Silicon Valley ist?

Das wäre ein Punkt. Das heißt, man müsste über einen Dezentralisierung nachdenken, da gibt es tolle Versuche, wie Blockchain oder Peer-To-Peer-Netzwerke, dass man die Kontrolle sozusagen verteilt.

Man müsste mal überlegen, ob man das nicht in die öffentliche Hand legen kann, so ein Tool. Und wenn man ganz utopisch wird und es wirklich ernst meint mit Demokratie, was ja auch Zuckerberg sozusagen die ganze Zeit propagiert, dann müsste man doch ganz anders agieren, als dass da nur hinter verschlossenen Türen Regeln für die ganze Welt entschieden werden.

Dann müsste man doch eher so etwas wie eine digitale UN, Vereinte Nationen, aufbauen und sagen: Jetzt wollen wir wirklich Nutzerinnen und Nutzer aller Mitgliedsstaaten involvieren und an einen virtuellen Tisch setzen und darüber debattieren, demokratisch debattieren, was auf diesen Plattformen erlaubt ist und was nicht.

Das wäre ein richtiger und wichtiger nächster Schritt, um das wirklich ernst zu nehmen.

Das wäre ein sehr aufwendiges Unterfangen, für das alle Staaten von der Notwendigkeit überzeugt sein müssten, was offensichtlich nicht der Fall ist. Haben Sie den Eindruck, dass das Potenzial und auch die Gefahren von Facebook und anderen Netzwerken immer noch stark unterschätzt wird?

Riesewieck: Ja, absolut. Diese sozialen Netzwerke versuchen uns ja weiszumachen, dass es möglich sei, objektive Richtlinien zu erlassen – und zwar statische Richtlinien, die nur hin und wieder etwas nachjustiert werden müssen –, die dann exekutiert werden können von jungen philippinischen Arbeitern. Denen muss man ja auch nicht viel zahlen, und die müssen auch nicht viel können, die haben ja objektive Richtlinien an der Hand und müssen sie nur noch ausführen.

Das ist der große Irrsinn daran. Denn es ist nicht möglich, einfach nur anhand dieser Richtlinien zu arbeiten. Es ist immer eine Ermessenssache, die ganze Zeit. Es geht immer darum Einzelfälle zu beurteilen, und das macht das ganze Thema so komplex.

Das heißt, man braucht unbedingt qualifizierte Mitarbeiter aus aller Welt, die die verschiedenen kulturellen Kontexte einschätzen können, die so etwas wie Ironie, Sarkasmus, Satire und so weiter je nach kulturellem Hintergrund unterschiedlich einschätzen können.

Aber das ist natürlich extrem kostspielig, denn dafür braucht man schon Redakteure mit einer entsprechend hohen Qualifikation.

Wir beide haben, glaube ich, auch gewisse Sympathien zu sagen: Naja, wenn das kein klassisches Medium werden soll und man an dem Gedanken festhalten will, die Nutzerinnen und Nutzer selbst mehr zu beteiligen - also im Sinne der ursprünglichen, utopischen Idee des Internets -, dann kann man das ja überlegen.

Man kann ja auch überlegen, andere Formen von Demokratie da zu etablieren. Im Sinne von Abgesandten, so etwas wie ein Repräsentantenhaus der Nutzerinnen und Nutzer, das immer wieder neu besetzt werden kann. Nur müssen die Tools dafür erst mal geschaffen werden.

Dann muss man's ernst meinen und die Strukturen dafür schaffen, dass solche Abstimmungsprozesse stattfinden und die Leute zusammenfinden. Liquid Democracy – das ist ja alles möglich, die Leute müssen ja nicht mehr an einem Ort zusammenkommen, um Entscheidungen zu treffen. Es können auch unterschiedliche Entscheidungen für unterschiedliche Weltregionen sein.

Die Richtlinien von Facebook zum Beispiel sind doch jetzt auch schon von Land zu Land unterschiedlich.

Block: Eben. Aber diese Tools müssen erst mal her und das Bewusstsein dafür muss da sein, dass es, obwohl es so kostspielig ist, sich lohnt, weil es die Grundvoraussetzung dafür ist, dass diese Netzwerke weiter bestehen können.

Denn so, wie es jetzt gerade gehandhabt wird, sind es keine zufälligen, bedauerlichen Fehler, die ab und zu geschehen, sondern ganz systematische Fehler, die auf das Konto dieser Unternehmen gehen, weil sie Geld sparen wollen.

Welche Fehler meinen Sie?

Riesewieck: Es passieren ja dauernd solche angeblich bedauerlichen Fehler, dass irgendwelcher Content verschwindet. In den wenigsten Fällen erfahren wir ja überhaupt davon.

Das passiert ja eigentlich nur dann, wenn Nutzerinnen und Nutzer eine Lobby haben oder sich an die Presse wenden oder es sonstwie zufällig rauskommt. In den allermeisten Fällen, und das macht man sich gar nicht bewusst, verschwindet Content jeden Tag in Tausenden, Zehntausenden Fällen, ohne dass wir irgendetwas davon mitbekommen.

Und wir wollen zeigen, dass das nicht nur schade ist für Einzelpersonen, sondern oft viel Menschen auf einmal betrifft und ganze Volksgruppen mundtot machen kann.

Oder anders herum, wie bei dem aktuellen Genozid in Myanmar, kann ein solcher Hass, wie er auf die dortige Minderheit der Rohingya entbrannt ist und der den Genozid erst in dieser Größenordnung ermöglicht hat, durch bestimmte Posts stark befeuert werden, wenn dann andere Posts, die ihn entkräften oder relativieren würden, gar nicht erst auftauchen oder sofort wieder verschwinden.

Und in vielen Ländern unterscheiden die Menschen gar nicht zwischen Facebook und dem restlichen Internet. Sie kennen den Unterschied nicht. Für sie ist Facebook das Internet.

Wie reagieren Facebook und die anderen Unternehmen auf Ihre sehr kritische Arbeit?

Block: Gar nicht, leider, zu unserer großen Enttäuschung. Diese Firmen sind grundsätzlich sehr verschlossen. Wir haben ihnen im Laufe der Jahre viele Anfragen geschickt, die alle unbeantwortet blieben.

Als der Film fast fertig war, haben wir ihn im Silicon Valley rumgeschickt, unter anderem, weil wir gehofft haben, dass Reaktionen kommen, die wir vielleicht noch hätten einbauen können. Aber: nichts.

Das ist ein Merkmal dieser Industrie: absolute Verschlossenheit. Und wenn sie von sich aus etwas veröffentlichen oder sich an die Presse wenden, dann geschieht das alles nur in höchst inszenierter Form.

Wobei Facebook sich selbst als Ort der uneingeschränkten Redefreiheit präsentiert.

Riesewieck: Ja. Facebook handelt völlig anders, als es vorgibt zu handeln. So ergeht es auch den Content-Moderatorewn auf den Philippinen. In den Stellenausschreibungen steht nicht, um was es wirklich geht. Da steht vielleicht "Datenanalyst", und die Bewerber erfahren erst hinterher, dass es um digitale Drecksarbeit geht.

Sie müssen sich verpflichten zu verheimlichen, was sie tun. Das geht so weit, dass sie auch untereinander einen Code benutzen müssen. Sie sagen niemals "Ich arbeite für Facebook", sondern so etwas wie "Ich arbeite für das Honey Badger Project“.

Block: Und die Philippinen sind ein tief katholisches Land. Diese Content-Moderatoren sind zum großen Teil tiefgläubige und überzeugte Katholiken, die stolz darauf sind, was sie tun, weil sie die Sünden der Welt auf sich nehmen wie Jesus Christus.

Und diese Menschen, die einerseits von ihrer Arbeit mental zerrüttet werden, müssen andererseits anhand von vagen Richtlinien nach eigenem Ermessen entscheiden, was wir sehen sollten und was nicht.

Wir müssen uns also auch die Frage stellen: Wollen wir es wirklich religiösen Fanatikern überlassen, unsere Inhalte zu kontrollieren?

In Dortmund aufgewachsen, musikalische und kunsthistorische Ausbildung, journalistische Ausbildung bei den Ruhr Nachrichten. Seit 2011 Kulturredakteur für Dortmund. Berichtet über Kunst, Kultur, Kulturpolitik und alles, was man sehen, hören, fühlen, glauben oder verstehen kann.